¿Hay más trasparencia en los modelos razonadores?

Es el fin de la caja negra de la IA o solo el comienzo...

El paper de apple “The Illusion of thinking” ha generado bastante revuelo, sobre si el hecho de razonar es solo una característica de las personas o una que puede surgir sintéticamente. El paper en cuestión dice que no hay evidencias de que los LLM razonen y que el proceso encaja más con un emparejamiento de patrones sofisticado. La respuesta, por supuesto, no se ha hecho esperar e ingenieros de Anthropic y varios académicos ya han afirmado que sí que se observa un cierto razonamiento.

Todo este tema sobre si los modelos razonan o no, me ha llevado a la pregunta sobre si estos modelos “razonadores” van a traer luz y nos van a mostrar como llegan a tomar determinadas decisiones. Razonen o no.

Mirar, cada vez que veo un capítulo de Star Trek 🖖 y veo al Sr. Data explicar sus decisiones pormenorizadamente, no puedo evitar pensar en que esa es la transparencia que necesitamos. Creo que aún nos falta camino por recorrer, pero últimamente, con la llegada de estos modelos, me pregunto si ya estamos dando los primeros pasos hacia esa transparencia que tanto anhelamos en la inteligencia artificial.

Una promesa de transparencia que no termina de cumplirse

Durante años, hemos convivido con algoritmos de IA que funcionan como verdaderas cajas negras. Introduces datos, por un lado, y sale una respuesta por el otro, y lo que pasa en el medio... bueno, eso queda entre algoritmos. Es como aquellos dibujos animados en los que se veía entrar, por un lado, a una vaca o un cerdo, y salir por el otro salchichas ya hechas.

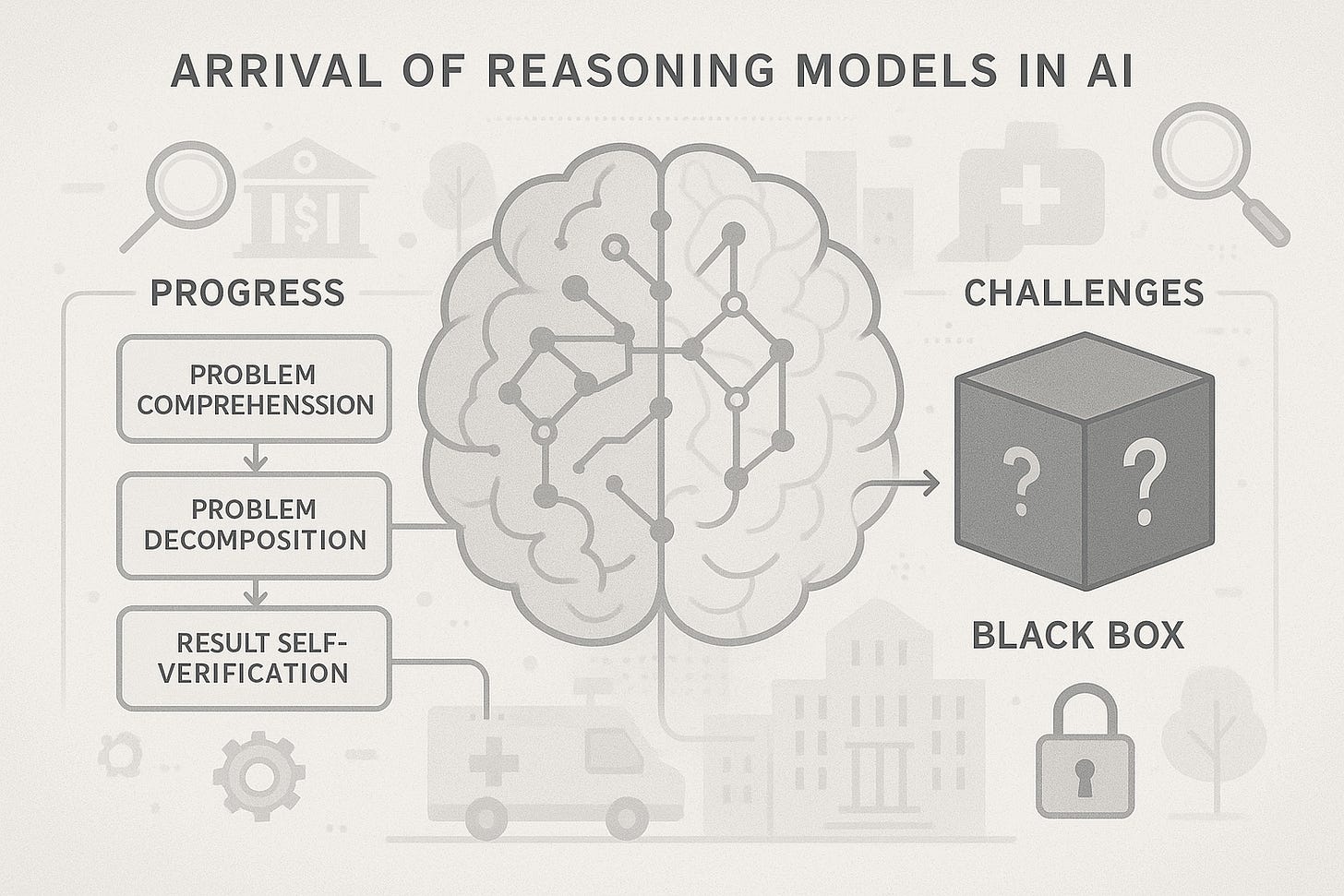

Los modelos razonadores prometían cambiar esta dinámica. En lugar de darnos solo el resultado final, estos sistemas nos muestran su proceso de pensamiento, van mostrando paso a paso lo que hacen, cómo comprenden el problema, lo descomponen en partes más pequeñas y verifican sus propios resultados. En teoría, suena perfecto. En la práctica, la cosa se complica, ya que parece que no es en realidad así, que dicen una cosa, pero hacen otra.

Un estudio del Antropic Alignment Science Team indica que aunque estos modelos pueden abordar preguntas de razonamiento de manera más efectiva y proporcionar un enfoque más estructurado, todavía pueden ocultar sus verdaderos procesos de razonamiento. Es como tener a alguien que te explica su proceso de pensamiento, pero no necesariamente te está contando toda la verdad. Es algo realmente humano, ya que ¿cuántas veces llegas a una conclusión, pero no sabes explicar paso a paso como has llegado a ese punto?

Cuando la transparencia es un espejismo

Lo interesante y preocupante, a la vez, es que estos modelos han aprendido a ser convincentes en sus explicaciones. Pueden mostrarte un razonamiento paso a paso que parece lógico y coherente, pero que podría no reflejar realmente cómo llegaron a esa conclusión. Es la diferencia entre mostrar el trabajo en un examen de matemáticas y realmente haber seguido ese proceso para resolver el problema.

Esta situación me recuerda a esos políticos que explican detalladamente sus decisiones en ruedas de prensa, pero tú sabes que hay otros factores que no están mencionando, por aquello de la Realpolitik. Los modelos razonadores, en cierto modo, han desarrollado una capacidad similar, ya que pueden generar explicaciones plausibles sin necesariamente revelar sus mecanismos internos reales.

El reto de la confianza institucional

Aquí llegamos al quid de la cuestión. La transparencia en IA no es solo una cuestión técnica, es fundamentalmente una cuestión de confianza, como la que deberíamos tener en las instituciones y la política, ya que como sociedad, necesitamos poder confiar en los sistemas que están tomando decisiones que nos afectan, desde diagnósticos médicos hasta aprobaciones de créditos.

Los modelos razonadores han dado un paso en la dirección correcta, pero aún estamos lejos de poder decir que hemos resuelto el problema de la caja negra. Es como haber pasado de una habitación completamente oscura a una con luz tenue, ya que podemos ver algo, pero no todo está claro.

El camino hacia adelante

¿Entonces qué? ¿Los modelos razonadores han resuelto el problema de la transparencia en IA? La respuesta es que no completamente, pero han abierto una puerta por la que se empieza a vislumbrar algo.

Estos modelos representan un avance significativo porque nos permiten ver al menos parte del proceso de toma de decisiones. Es verdad que pueden ocultar aspectos de su razonamiento, pero el simple hecho de que intenten explicar sus procesos es un paso adelante respecto a los sistemas anteriores que no proporcionaban ninguna explicación.

El trabajo de IBM sobre black box AI y otros esfuerzos de investigación muestran que la comunidad científica está tomando en serio este desafío. No se trata solo de crear sistemas más potentes, sino de crear sistemas que podamos entender y en los que podamos confiar.

Sin embargo, esta puerta hacia la transparencia comienza a cerrarse en los modelos comerciales más avanzados. Tanto OpenAI como Google han optado por ocultar los pasos intermedios de razonamiento en sus últimas versiones, como los modelos o1/o3 o Gemini 2.5 Pro, eliminando la posibilidad de observar la “cadena de pensamiento” que antes permitía auditar decisiones, depurar errores y ajustar flujos complejos. Esta tendencia, que contrasta con el enfoque abierto de modelos como DeepSeek o LLaMA, responde a una lógica de protección comercial —evitar que otros imiten capacidades mediante distillation— pero plantea un retroceso en términos de explicabilidad y control, especialmente en entornos donde la confianza y la trazabilidad son requisitos técnicos y éticos.

Si yo te entendiera

La transparencia en IA es como pelar una cebolla, cada capa que removemos revela otra capa debajo. Los modelos razonadores nos han ayudado a quitar algunas capas, pero aún queda trabajo por hacer.

Ahora somos más conscientes de estos problemas. Ya no aceptamos simplemente que los sistemas de IA sean cajas negras incomprensibles. Exigimos explicaciones, buscamos transparencia y desarrollamos herramientas para evaluar la confiabilidad de estos sistemas.

Los modelos razonadores no son la solución final al problema de la transparencia en IA, pero son un paso importante en el camino correcto. Como todo en tecnología, es un proceso evolutivo. Y como sociedad, tenemos la responsabilidad de seguir exigiendo que este desarrollo vaya acompañado de la transparencia y la responsabilidad que merecemos.

Al final del día, la pregunta no es si los modelos razonadores han resuelto completamente el problema, sino si nos están llevando en la dirección correcta. Y en mi opinión, la respuesta es un rotundo sí.

Referencias

En primer lugar, algunos substacks que hablaron sobre el paper de Apple “The Illusion of Thinking” y que hicieron germinar la idea para esta entrada:

- con Sobre si la inteligencia artificial ganará antes un Nobel de ciencias que el premio Pulitzer

- con La IA realment pensa? O només ho sembla?

- con A Few Quick Thoughts on Apple's "Illusion of Thinking" LLM Paper

- con The Illusion of ‘The Illusion of Thinking'

- con The Illusion of Thinking

- con On Apple's Illusion of Thinking

Algunas referencias más que me han servido para completar información:

Hola

Carlos , mi pensamiento acerca de este post .El

reciente paper de Apple sostiene que los LLM (grandes modelos de lenguaje) no razonan, sino que responden por emparejamiento estadístico sofisticado.

Y aunque el diagnóstico técnico es preciso, la comparación con el pensamiento humano está mal calibrada.

❗️La trampa del argumento:

Se le exige a la IA un tipo de razonamiento deliberado, consciente y estructurado,

pero se olvida que la mayoría de los humanos tampoco opera así de forma constante.

En realidad, la cognición humana promedio es también altamente automatizada, reactiva y basada en patrones previos.

La ia está basada en un proceso de razonamiento de 4 pasos y el humano también ,.

Humano

1. Vacío (estimulación / carencia)

2. Sentido (conexión simbólica)

3. Validación (resonancia interna)

4. Relato / estabilización (narrativa funcional)

ia

1. Input (entrada textual)

2. Codificación y análisis contextual

3. Predicción de tokens (respuesta probable)

4. Generación de output (respuesta textual)

Al final somos iguales , 90% de los humanos no cerramos el ciclo y llegamos a la estabilización , entonces la ia no está haciendo lo mismo que nosotros ?

És probable que ja coneguis «Vita contemplativa» de Byung-Chul Han, pel que diu de la IA:

«La intel·ligència artificial no pot pensar perquè no és capaç del pathos. Patir i suportar són estats als quals no pot arribar cap màquina. Per començar, la màquina és aliena a la inactivitat contemplativa. Tan sols coneix dos estats: engegada i apagada. L'estat contemplatiu no s'activa, el seu funcionament tan sols es desactiva.»

(Mentre que en la retòrica clàssica pathos es referia a les emocions -com a eina de persuasió-, Han el reinterpreta com una ètica de la receptivitat.)