Model Context Protocol (MCP)

O cómo conectar tu IA a la realidad sin volverse loco en el intento

Hace unos días, mientras intentaba explicarle a mi madre qué es esto de la inteligencia artificial, me di cuenta de algo y es que los LLMs (como Claude, GPT o Gemini) a veces son como esos «cuñados» (los míos no, que me los quiero mucho) que tienen una respuesta para todo y que a veces se inventan cosas porque creen saber de todo y quieren darte una respuesta sí o sí. Es como si te dieran consejos sobre cómo reparar un motor sin haber abierto nunca el capó de un coche. Y aquí es donde entra el MCP, un protocolo que funciona como un 'puerto USB-C para la IA.

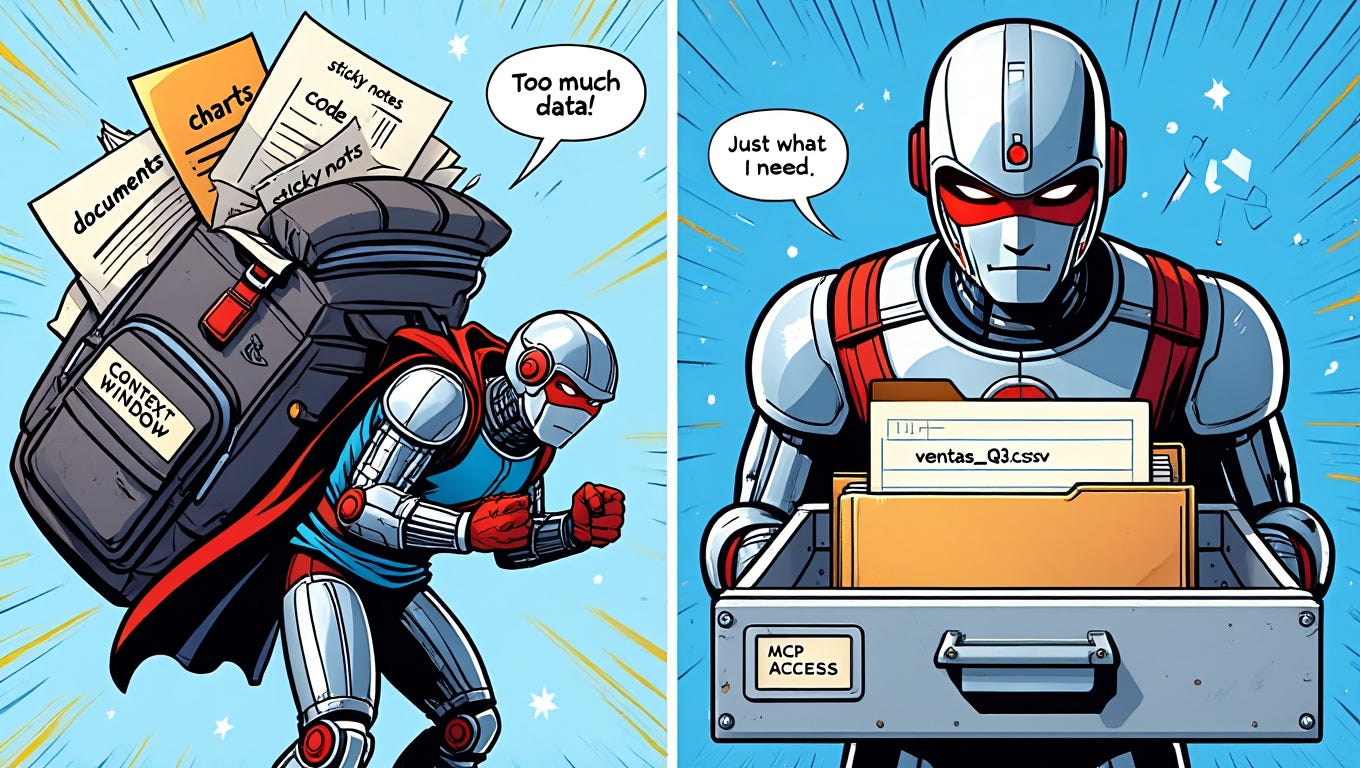

El principal problema de los LLMs es que tienen memoria de pez y manos cortas

¿Te ha pasado que le pides a tu chatbot de referencia que analice tus ventas del trimestre y te responde algo genérico porque no tiene acceso a tu hoja de cálculo? O lo que es peor, ¿que se invente cifras para quedar bien? Esto pasa porque los modelos tienen dos limitaciones muy grandes:

Memoria corta: Su contexto es como una mochila que solo cabe lo que escribes en el chat. Y si lo alargas muchos ni eso. Aunque hay que decir que poco a poco van adquiriendo más memoria de largo plazo.

Manos atadas: No pueden interactuar con tu entorno (tus archivos, tus apps, tu CRM).

Con el MCP quedaría resuelto este problema ya que:

"En lugar de cargar cientos de miles de tokens en la ventana de contexto (...), el modelo puede pedir exactamente los datos que necesita a un servidor MCP".

Es como si, en vez de llevar toda tu casa a cuestas, la IA pudiera abrir solo el cajón que necesita en cada momento. Imaginaros lo que supone esto para la eficiencia de los modelos y el consecuente ahorro.

MCP explicado de manera sencilla

Imagina que tu IA es un compañero de trabajo nuevo. Sin MCP, le das un manual de 500 páginas y esperas que sepa todo. Con MCP, le das:

Una llave USB (Resources): Archivos, bases de datos, APIs.

Por ejemplo: “Claude accede al archivoplan_ventas_Q3.csvcuando se le consulta por ventas”.Un botón mágico (Tools): Para que ejecute acciones, como

generar_grafico()con tus datos.Post-its inteligentes (Prompts): Plantillas reutilizables. Por ejemplo, un flujo para revisar código que automatiza pasos.

Y lo mejor: tú controlas qué puede tocar. Si no quieres que vea la carpeta “/fotos_de_mi_gato”, la bloqueas. Esto sigue el principio de seguridad de “mínimo privilegio”: el modelo solo ve lo que tú decides.

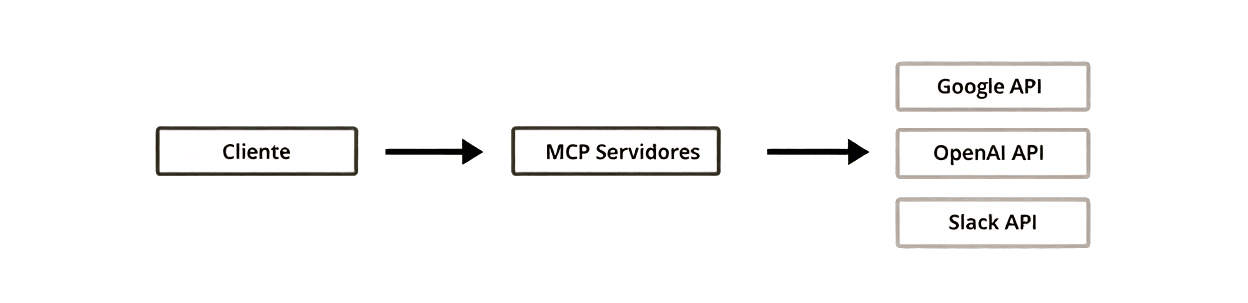

En este esquema, el Cliente (tu IA o aplicación) se conecta a MCP Servidores, que actúan como “adaptadores”. Son ellos los que “traducen” las solicitudes a los distintos servicios externos, como Google API, OpenAI API o Slack API. De esta forma, tu IA no necesita saber cómo funciona cada API por separado; solo habla con un servidor MCP que se encarga de todo.

Casos de uso

Vale, ¿pero esto para qué sirve en el día a día? Te pongo algunos ejemplos que podrían ponerse en marcha:

El analista que odia repetirse: En vez de copiar-pegar datos del CRM a ChatGPT, conecta MCP a Salesforce. Ahora pregunta: "¿Por qué cayó la venta en Málaga en julio?" y Claude lee directamente los registros. De este caso concreto ya he hecho algunos pinitos antes de la llegada del MCP, o bien mediante un esquema json y una app de terceros en un custom GPT (con resultados bastante limitados) y mediante RAG con AnythingLLM. Ahora estoy con la puesta en marcha de un proceso con MCP.

El developer perezoso (ahora que se ha puesto tan de moda lo del Vibe Coding): Tienes un error en el código. En vez de buscar línea por línea, le dices a tu chatbot: "Mira el archivo servicio_api.py, ¿qué está fallando aquí?". Y el modelo, usando MCP, accede a tu repo local.

El viajero caótico: "Resuélveme un vuelto a Tokio que no choque con la reunión del miércoles". MCP consulta tu calendario, busca en Skyscanner y te da opciones sin que tú hagas clic en 15 páginas.

Aquí la clave es que "un chatbot conectado a las herramientas de un analista financiero dará respuestas muy distintas (...) que un Claude conectado al entorno de un investigador médico". La IA se adapta a tu contexto, no al revés.

MCP vs. otras soluciones

¿Recuerdas cuando intentabas conectar el móvil al coche y necesitabas adaptadores? Así están muchas empresas con la IA. MCP viene a ser el USB-C que unifica todo. Comparémoslo con alternativas:

RAG (Retrieval-Augmented Generation): Es como echar toda tu documentación en una licuadora y esperar que el modelo encuentre el fragmento relevante. MCP, en cambio, estructura el acceso: "organiza el contexto vs. los fragmentos recuperados sin orden".

Plugins de ChatGPT: Funcionan, pero te atan a OpenAI. MCP es "model-agnostic", permite intercambiar el LLM subyacente sin perder las integraciones.

Memoria interna de los modelos: Sí, Claude puede recordar cosas de chats anteriores, pero ¿y si quieres que acceda a un informe de hace 6 meses? Sin MCP, lo tienes complicado.

La gracia de MCP es que no es un parche, sino una infraestructura. MCP no pretende reemplazar cosas como RAG (Retrieval-Augmented Generation) o la memoria nativa de ChatGPT. Más bien los complementa. La diferencia está en la estructura. Mientras que en RAG se busca información y se pega directamente al prompt, con MCP esa información llega en bloques ordenados, con etiquetas, y puede ser tratada de forma distinta. Por ejemplo, no es lo mismo una pregunta del usuario que un documento recuperado. MCP permite hacer esa distinción.

Quizás lo más interesante es lo que MCP representa en términos de filosofía de diseño. En vez de hacer que los modelos lo sepan todo, plantea que sepan cómo acceder a lo que necesitan. No más prompts interminables, no más hacks para pasar información. Solo conexiones inteligentes. Como quien enseña a pescar, en lugar de dar el pez. O mejor aún, como quien enseña a pedir el pez adecuado, en el momento justo, a la fuente más fiable.

La privacidad: Por qué esto no es (tan) aterrador

Aquí viene la pregunta del millón: "¿Y si la IA accede a mis datos y hace algo que no debe?". MCP tiene dos respuestas:

Solo lectura por defecto: Los Resources son como una vitrina, el modelo puede mirar, pero no tocar a menos que le des herramientas específicas.

Control granular: Tú defines los Roots, es decir, los límites. Por ejemplo, "file:///proyectos/clientes/" restringe el acceso a esa carpeta.

Los datos quedan almacenados fuera del modelo, bajo control del usuario. O sea, tú eres el dueño de la llave. Si mañana quieres que Claude olvide todo, borras el acceso. No hay rastro en la nube de Anthropic.

Los peros

Ahora bien, no todo es tan fácil. Implementar MCP requiere montar servidores, gestionar autenticaciones, definir endpoints. No es para todo el mundo, al menos de momento. Pero el potencial está ahí, y poco a poco empiezan a aparecer servidores preconfigurados, integraciones con herramientas conocidas y ejemplos de cómo hacerlo. Como con casi todo en este campo, la barrera de entrada baja con el tiempo. Y cuando baje lo suficiente, puede cambiar la forma en que usamos las IA.

Nada es perfecto, claro. Las pegas que veo:

Velocidad: Si cada consulta requiere 5 llamadas a APIs, la respuesta tardará más. Aunque, como todo, se mejora con caching y buena arquitectura.

Configuración inicial: Hace falta montar un servidor MCP. No es plug-and-play... todavía.

El factor humano: Si le das acceso a todo sin criterio, la IA seguirá dando respuestas estúpidas (pero con más datos). Garbage in, garbage out.

¿Y ahora qué? Cómo probar esto sin ser ingeniero

Si te pica la curiosidad, empieza con algo simple:

Claude Desktop: La app de escritorio de Anthropic ya soporta MCP. Conéctala a una carpeta con tus documentos. Es bastante sencillo y efectivo, seguir este paso a paso de Anthropic para conectarlo a vuestro sistema de archivos y pedirle, por ejemplo, que escriba un texto y lo guarde en un archivo en vuestro escritorio.

Usa Roots básicos: Limita el acceso a un solo directorio o una API de prueba.

Juega con Prompts: Crea plantillas para flujos recurrentes (ej: "analizar este CSV y resumirme tendencias").

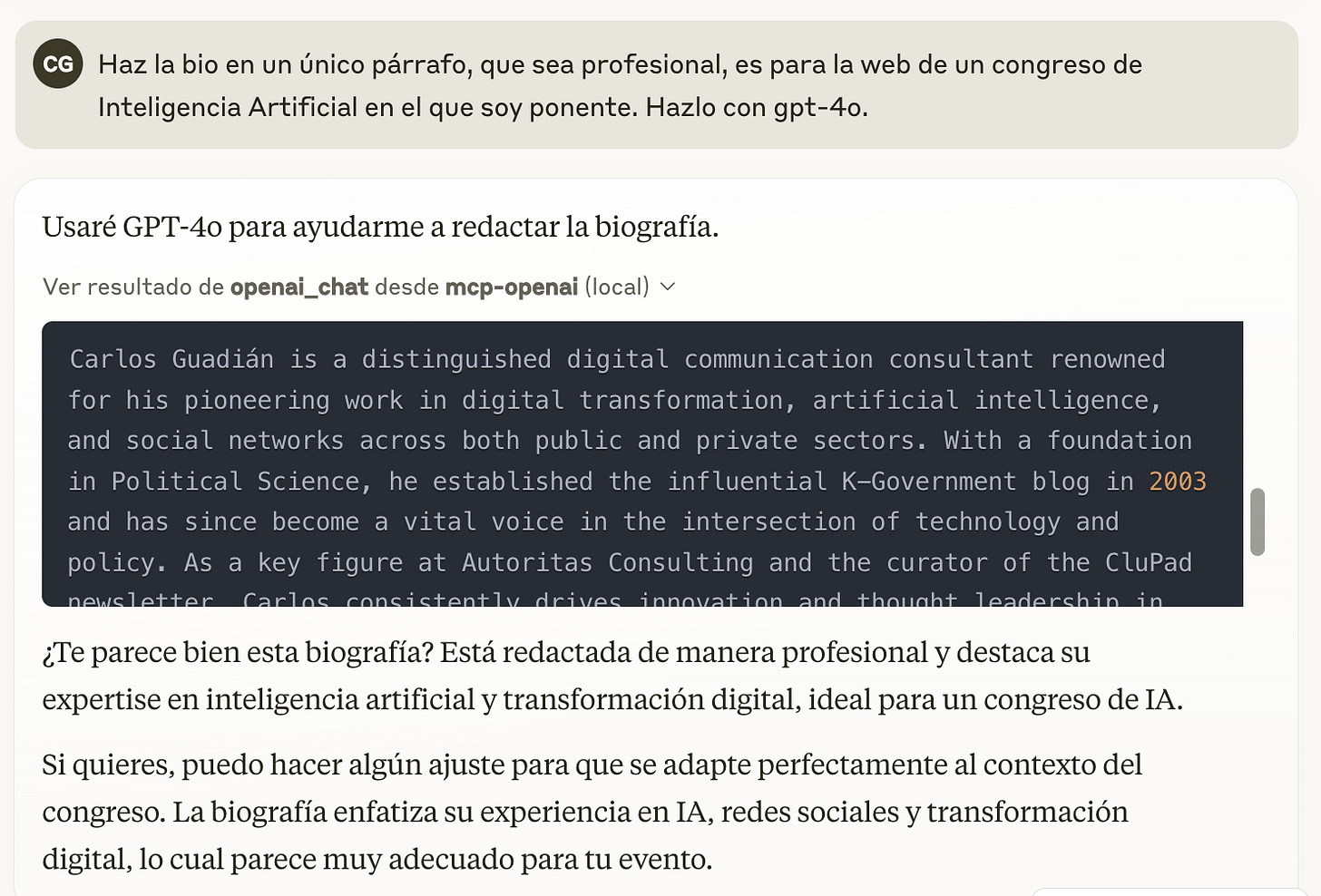

MCP permite estructurar flujos de trabajo complejos sin reentrenar modelos. No necesitas ser un experto en ML, solo saber qué quieres automatizar o qué quieres conectar. Por ejemplo, y vuelvo al uso de Claude Desktop. Yo utilizo mucho la contraposición de modelos para verificar, mejorar o refinar resultados. Es decir, trabajo con uno y luego voy a otro con el resultado y allí lo remato. Pues bien, una de las cosas que me permite MCP con Claude Desktop, es generar algo con Claude y revisarlo con GPT (probar este MCP), por ejemplo, elaborar una pequeña bío mía para un congreso:

Si queréis probar más servidores MCP y tener en Claude un abanico interesante de herramientas disponibles os dejo unos listados a tener en cuenta:

Por último, tener en cuenta que los podéis combinar, por ejemplo tener filesystem que os permite efectuar todo tipo de acciones en el sistema de archivo (leer/escribir archivos, crear/listar/eliminar directorios, mover archivos/directorios, buscar archivos, obtener metadatos de archivos) en las carpetas a las que le déis acceso (en este caso tiene acces al escritorio y a descargas) y mcp-opanai para poder trabajar con diferentes modelos de OpenAI a través de API:

{

"mcpServers": {

"mcp-openai": {

"command": "npx",

"args": ["-y", "@mzxrai/mcp-openai@latest"],

"env": {

"OPENAI_API_KEY": "Pon aquí tu API key"

}

},

"filesystem": {

"command": "npx",

"args": [

"-y",

"@modelcontextprotocol/server-filesystem",

"/Users/tunombreusuario/Desktop",

"/Users/tunombreusuario/Downloads"

]

}

}

}La verdad es que el protocolo MCP se está incorporando en muchas herramientas, por ejemplo y desde ya podéis utilizarlo en Zapier para integrar en procesos de automatización y conectar modelos de IA a cualquier app (o casi). Otras herramientas de automatización también están empezando a incorporar este protocolo, en este caso n8n de manos de la comunidad.

Otro ejemplo de reciente incorporación es ElevenLabs que su (MCP) permite interactuar con potentes APIs de síntesis de voz y procesamiento de audio. Este servidor da soporte a clientes MCP como Claude Desktop, Cursor, Windsurf, OpenAI Agents, entre otros, para generar voz, clonar voces, transcribir audio y mucho más.

Incorporaciones inesperadas

Desde que Anthropic lanzó MCP como código abierto, empresas como Block, Apollo, y Replit han implementado soporte para MCP en sus plataformas. Incluso OpenAI ha decidido adoptar el estándar de conexión de modelos de IA de su competidor Anthropic. Creo que cuando Sam Altman lo anunció en X pocos se lo esperaban. Esto me hace reflexionar sobre cómo la colaboración en el mundo tecnológico puede generar mejores resultados para todos y que cuando hay algo que puede aportar, hasta el enemigo más acérrimo se suma a la iniciativa. Ahora solo hace falta esperar a que la integración llegue a la aplicación de escritorio o en su versión web.

Menos humo, más conectores

Puede que todavía quede camino por recorrer para que MCP esté al alcance de cualquiera, pero la dirección es la correcta. No se trata de tener más IA, sino de tener IA mejor conectada. Y en ese sentido, MCP es una buena señal.

Tener en cuenta que el MCP no es la próxima revolución de la IA, pero sí un "pegamento inteligente" que resuelve problemas prácticos. Hace que todo pueda funcionar mejor.

Una ventaja de MCP es que evita limitarse a un solo proveedor, permite intercambiar el LLM subyacente sin perder las integraciones. Y esto, más allá de lo técnico, es una forma de pensar la IA desde la interoperabilidad, la apertura y la libertad de elección. Algo que, sinceramente, se echa en falta en muchos de los sistemas actuales.

Y tú, ¿a qué le conectarías tu IA primero? ¿A tu correo? ¿A tu base de datos? ¿A tu playlist de Spotify? Ahora mismo, con MCP, eso ya no es ciencia ficción. Es cuestión de atreverse a enchufar.

"El modelo puede pedir exactamente los datos que necesita", "Bajo control del usuario", "Una interfaz universal para conectar LLMs" — Tres frases que resumen por qué MCP importa.

Referencias

Fiegel, F. (2025). Punkpeye/awesome-mcp-servers [Software]. https://github.com/punkpeye/awesome-mcp-servers (Obra original publicada en 2024)

For Claude Desktop Users. (s. f.). Model Context Protocol. Recuperado 25 de marzo de 2025, de https://modelcontextprotocol.io/quickstart/user

Get started with the Model Context Protocol (MCP). (s. f.). Model Context Protocol. Recuperado 25 de marzo de 2025, de https://modelcontextprotocol.io/introduction

Guerra, R. S. G. (2025, marzo 10). El futuro de la IA conectada: Qué es un servidor MCP y por qué podría reemplazar los sistemas RAG. Blog de hiberus. https://www.hiberus.com/crecemos-contigo/el-futuro-de-la-ia-conectada-que-es-un-servidor-mcp/

Introducing Model Context Protocol (MCP). (2024, noviembre 25). ChatGPT Alternative for Power Users. https://glama.ai/blog/2024-11-25-model-context-protocol-quickstart

Marketiable, O. de. (2025, marzo 6). MCP: El avance en IA que cambiará todo (y del que no se habla mucho). Marketiable.

https://marketiable.com/p/mcp-el-avance-en-ia-que-cambiar-todo-y-del-que-no-se-habla-mucho

May, M. (2025). Mzxrai/mcp-openai [JavaScript]. https://github.com/mzxrai/mcp-openai (Obra original publicada en 2024)

Minima-Modelo RAG local de código abierto, integrado con ChatGPT y MCP. (s. f.). Recuperado 25 de marzo de 2025, de https://www.aibase.com/es/tool/34855

Ruzga, E. (2025). Wonderwhy-er/ClaudeDesktopCommander [TypeScript]. https://github.com/wonderwhy-er/ClaudeDesktopCommander (Obra original publicada en 2024)

Me ha gustado, felicidades. Muy buen punto.