En Internet, nadie sabe si eres humano

💬 ¿dónde queda lo Humano? 🤖👤 Descubre cómo la IA nos reta a mantener nuestra esencia en un mundo automatizado #IdentidadDigital

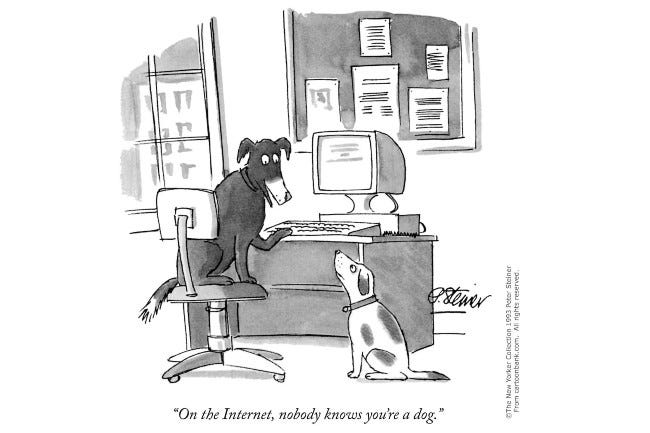

Peter Steiner, un dibujante de caricaturas para The New Yorker, creó una de las caricaturas más populares y conocidas de la revista en 1993. La caricatura representaba a un perro sentado frente a un ordenador con el pie de imagen «En Internet, nadie sabe que eres un perro». En ese momento, Internet seguía siendo un misterio para la mayoría de las personas, y el anonimato online era la norma. Ahora, el problema, es que nadie sabe si eres humano.

La pérdida del anonimato

En la década de 1990, cuando apareció la famosa caricatura del «perro», el anonimato en Internet era común y no era difícil mantenerse sin identificar. Con el aumento de los usos comerciales de Internet y la introducción de cookies, permitió a los servidores rastrear a los usuarios a lo largo de sus sesiones. Se ha buscado durante mucho tiempo acabar con ese anonimato y el gran salto se dio con la llegada de las redes sociales, concretamente de Facebook.

Se buscaba eliminar el anonimato y rastrear a los usuarios con precisión para dirigir anuncios y vender sus datos (¿os acordáis de Cambridge Analytica?). Y poco a poco se ha ido haciendo necesario identificarse en los sitios para comentar, para escribir y por supuesto para comprar. Esa obligación a identificarse a ido a la par con los sistemas de seguimiento de las diferentes plataformas y de las sospechas que los gobiernos se han aprovechado de ello para tenernos completamente identificados y situados en el mapa.

Todo son bots

La irrupción de ChatGPT a principios de año y la popularización de chatbots con base de inteligencia artificial ha copado la creación de contenido y en estos momentos podemos ver a estos «usuarios virtuales» por todos los sitios que podamos imaginar. No son solo asistentes virtuales, también se han convertido en usuarios que pretenden animar las conversaciones y en muchas ocasiones acaba ocurriendo que son chatbots los que hablan con chatbots.

Plataformas de redes sociales como Snapchat y Facebook están introduciendo amigos de IA, chatbots diseñados para interactuar con los usuarios y ofrecer diversas personalidades y capacidades. El creciente desarrollo de amigos de IA plantea preocupaciones sobre el posible narcisismo aprendido y la extrema toxicidad interpersonal. Este cambio en la relación entre la IA y los humanos podría tener profundas implicaciones para la sociedad, afectando las conexiones humanas y potencialmente exacerbando problemas como la soledad.

Por lo que hace al contenido ocurre algo parecido. La generación de contenido con IA es algo que tenemos al alcance de la mano. Hacer un resumen, una reseña, una lista de puntos a tener en cuenta, una propuesta de tweet, una traducción y eso tan solo si hablamos de texto. Imágenes, audio y video están en camino de ser contenidos fáciles de generar sin tener que complicarse demasiado con la ingeniería de prompts. El procesamiento del lenguaje natural hará poco a poco que los algoritmos sean capaces de entendernos, aunque tengamos la capacidad de comunicarnos de una ameba. Y el problema, como en el caso del texto, es que empiecen a generar contenido a petición propia, es decir, que los algoritmos sean los que pidan a otros algoritmos que generen contenido.

Esto nos lleva a una Internet en la que los algoritmos van a acabar alimentándose de sus propios contenidos, entrando en un círculo vicioso del que acabará saliendo una realidad distorsionada y modelada por modelos matemáticos y en la que la humanidad empezará a dejar de estar presente. Si las aplicaciones basadas en IA se alimentan del contenido generado en Internet, y si este ya se genera casi exclusivamente por IA, ¿va a aprender de sí misma? ¿Se va a montar su propia realidad? ¿Es necesario el contenido humano? Investigadores advierten que aprender de contenido generado por AI puede distorsionar nuestra percepción de la realidad. ¡Utilicemos datos producidos por humanos para mantener la integridad de los modelos! La alimentación recursiva de la IA generativa puede llevar al colapso del modelo. Cada generación amplifica errores y sesgos, afectando la calidad y confiabilidad de la IA.

Estamos llegando al punto en el que va a ser necesario identificarse como persona.

¿Los humanos podemos diferenciarnos de los bots?

Los chatbots de inteligencia artificial, como ChatGPT de OpenAI, tienen una fuerte tendencia a inventar información errónea, lo que puede llevar a desastres al confundir hechos con invenciones. Algunos expertos opinan que este problema no tiene solución, lo que podría afectar seriamente el avance de la tecnología. El caso es que la capacidad de cometer errores y decir mentiras es algo que compartimos humanos y algoritmos, es algo muy humano.

Pero más allá de las alucinaciones, hay toda una serie de características que pueden ser tenidas en cuenta para poder identificar usuarios falsos. Este artículo presenta un estudio de caso sobre una red de bots en Twitter que aparentemente utiliza ChatGPT para generar contenido similar al humano. Mediante heurísticas, se identificaron 1,140 cuentas que forman un denso grupo de personajes falsos con comportamientos similares, incluyendo la publicación de contenido generado por máquinas y el uso de imágenes robadas. El contenido generado por ChatGPT promueve sitios web sospechosos y difunde comentarios perjudiciales. Aunque es posible detectar estas cuentas a través de sus patrones de coordinación, los clasificadores de contenido más avanzados no pueden distinguir entre ellas y cuentas humanas legítimas. Estos hallazgos resaltan las amenazas que presentan los bots sociales habilitados por inteligencia artificial.

TE PUEDE INTERESAR » Por favor, sé amable con la IA

Demuestra que eres humano. Del Captcha a WorldCoin

En la actualidad, es difícil encontrar un sitio web con un formulario o algún tipo de solicitud de contenido, que no esté protegido por una prueba automatizada de verificación humana. Imagino que ya sabes de lo que hablo, ¿no? De esas pruebas que muestran una secuencia de caracteres en una imagen y solicita al usuario que ingrese la secuencia en un campo de entrada. Incluso puedes escucharla en algunos si no eres capaz de introducir correctamente la secuencia.

Este mecanismo de seguridad se basa en el Test de Turing, uno de los conceptos más antiguos de la Inteligencia Artificial, y se conoce como Prueba de Turing Pública Completamente Automatizada para Distinguir Computadoras y Humanos (CAPTCHA, por sus siglas en inglés – Completely Automated Public Turing test to tell Computers and Humans Apart). Estas pruebas se han pensado para evitar el acceso automatizado a recursos web, como un servicio de correo electrónico o una red social. Actualmente existen cientos de estas pruebas, que se sirven millones de veces al día, lo que implica una gran cantidad de trabajo humano. Sin embargo, algunas de estas pruebas han sido vulneradas, es decir, programas automatizados diseñados por investigadores, hackers y spammers han sido capaces de proporcionar la respuesta correcta automáticamente. (Más info en CAPTCHAs: An Artificial Intelligence Application to Web Security)

Y desde este punto de partida que son los captcha podemos seguir el rastro de nuevos métodos que se han ido implementando para asegurarse que una petición de servicio o un usuario tiene detrás realmente a una persona. Desde las pruebas de verificación social, dónde alguien ya identificado válida a otro usuario como persona, a los sistemas biométricos en los cuales, además de demostrar la humanidad, también se demuestra la unicidad.

Sam Altman ha puesto en marcha Worldcoin, una plataforma de identificación digital que utiliza tecnología de escaneo ocular para verificar la «prueba de identidad» de los usuarios. La plataforma también incluye una aplicación llamada World App que funciona como una billetera de criptomonedas y permite a los usuarios acceder a aplicaciones financieras descentralizadas (DeFi) de manera segura. Worldcoin ha recibido críticas y ha generado controversia debido a preocupaciones sobre la recopilación de datos personales y el respaldo de algunos nombres problemáticos en el espacio criptográfico. A pesar de esto, el concepto de «prueba de identidad» podría tener un gran valor si se implementa con éxito.

Por mi parte contaros mi experiencia con WorldCoin. Pese a las reticencias y las advertencias sobre los problemas de privacidad que puede suponer dejarse escanear el iris, decidí probar en primera persona de qué va. Primero de todo decir que la ubicación de los orbes para escanear el iris en Diagonal Mar (el sitio al que me dirigí) no es correcto, si están en el centro comercial, pero en una planta diferente. Cuando llegué me sorprendió el tipo de personas que estaban allí para darse de alta en WorldCoin. Dos parejas con hijos, de entre treinta y cuarenta años, vamos millennials en plan early adopter. Nada que ver con las colas de GenZ que se ven en algunos vídeos.

Tengo que decir, que la aplicación llevaba toda la mañana sobrecargada y que dudaba que pudiera darme de alta, y tal como temía, mis sospechas se cumplieron. Después de varios intentos, la chica al cargo de los dos orbes decidió reiniciarlos, ya que no conseguía dar de alta a ninguna de las personas que estaban allí. Y finalmente, viendo que no había manera, decidí irme – Sam has dejado escapar el iris de un boomer – y me vinieron a la cabeza las advertencias de Marta Peirano y pensé que si no tenía que ser, pues casi que mejor, una buena excusa para escapar de la vigilancia de OpenAI.

No sé si será finalmente WorldCoin, con todo lo que lleva implícito, el sistema universal de verificación humana. Pero lo que sí que sé es que más pronto que tarde empezaremos a ver contenidos certificados a modo de artesanía, que están hechos por humanos. Artículos, fotografías, vídeos, música… Acostumbraros a ver certificados «human proof», «made by human» o lo que se os ocurra. Pero como con todo, estos se acabarán apreciando más, igual que ocurre con aquellas cosas hechas manualmente, con inteligencia humana.

Claves a tener en cuenta, si eres humano, claro 😉

🐶 El poder de la caricatura «En Internet, nadie sabe que eres un perro» ilustra el anonimato en la era temprana de Internet.

📊 Evolución hacia la identificación en línea debido a la expansión de redes sociales y comercio electrónico.

🕵️♂️ Pérdida gradual del anonimato en la web y auge de las redes sociales.

👾 Chatbots y contenido IA, ¿amigos o distorsión digital?

🤖 Emergencia de chatbots e IA en la interacción humana y generación de contenido.

🌐 Preocupación por la influencia de algoritmos en la creación y percepción de la realidad.

🤖 Desafío de distinguir entre humanos y bots en plataformas digitales.

🧠 Humanos y bots comparten capacidad para errores y mentiras.

🔒 Importancia de mantener la integridad de modelos con datos producidos por humanos.

🧩 Pruebas de verificación humana, como CAPTCHAs, evolucionan hacia métodos biométricos como el escaneo ocular.

💡 Worldcoin y su concepto de «prueba de identidad» mediante tecnología de escaneo ocular.

👁️🗨️ Experiencia decepcionante al intentar registrarme en WorldCoin.

🌱 Creciente tendencia hacia la certificación de contenidos hechos por humanos en un mundo automatizado.

🌐 Contenidos «human proof»: el valor de lo auténtico en línea.

Va a ser un tema complicado, porque es muy difícil garantizar la privacidad y los derechos individuales, a la vez que se quiere luchar contra el anonimato. Porque para poder garantizar que una entidad que interactúa en Internet es humana, me temo que no habrá otra forma que no sea sacrificando el anonimato.

No iría hasta el punto de obligar a las personas a estar registradas en Internet para todo, pero sí que me gustaría que existieran entidades certificadoras a nivel nacional (controladas por los estados) que permitieran usar tu identidad en Internet cuando quisieras (sería ideal para hacer trámites), pero también tener la opción de optar por el anonimato, aunque eso suponga impedir que se te pueda distinguir de un bot.